Zelfmoordpreventie is een urgent maatschappelijk vraagstuk dat jaarlijks duizenden levens raakt. In Nederland speelt 113 Zelfmoordpreventie een cruciale rol in het bieden van laagdrempelige hulp via telefoon- en chatdiensten. De recente integratie van kunstmatige intelligentie (AI) binnen deze hulplijn heeft veelbelovende mogelijkheden opgeleverd. AI kan worden ingezet om hulpverleners te ondersteunen bij het analyseren van gesprekken, het verbeteren van interventies en het optimaliseren van dienstverlening. Maar hoe effectief is deze technologie en welke ethische overwegingen spelen een rol?

Salim Salmi, data specialist & onderzoeker bij 113 Zelfmoordpreventie, heeft zich gespecialiseerd in de toepassing van AI binnen 113 Zelfmoordpreventie. Tijdens zijn promotieonderzoek richtte hij zich op het gebruik van AI om de interacties binnen de hulplijn te analyseren en te verbeteren. Op 28 februari 2025 gaf hij een presentatie bij Pegamento tijdens een interne bijeenkomst, waarin hij de resultaten van zijn onderzoek en de implementatie van AI binnen 113 toelichtte. Zijn inzichten geven een uniek beeld van hoe AI kan bijdragen aan de ondersteuning van hulpverleners en de verbetering van crisisinterventies.

Inzichten uit de presentatie bij Pegamento

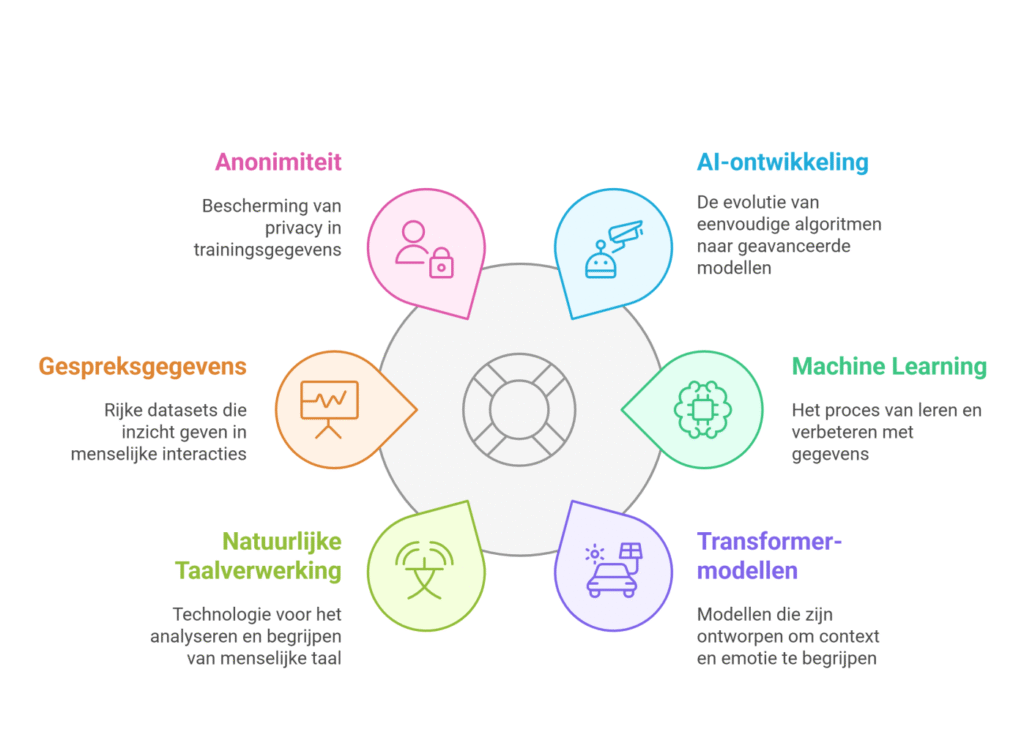

Tijdens de presentatie van Salim Salmi bij Pegamento werd dieper ingegaan op de praktische toepassingen en uitdagingen van AI binnen 113 Zelfmoordpreventie. Salmi besprak hoe AI-systemen aanvankelijk werden ontwikkeld met simpele zoekalgoritmen, maar al snel uitgebreid werden met machine learning en diepgaande tekstanalyses om de nuance van gesprekken beter te begrijpen.

Een belangrijk thema in de presentatie was de complexiteit van gespreksdata. Salmi legde uit dat standaard algoritmen onvoldoende zijn om de emotionele lading van gesprekken volledig te vatten. AI moet niet alleen woorden analyseren, maar ook de context en intentie achter uitspraken begrijpen. Hiervoor werd een transformer-model geïmplementeerd, gebaseerd op de GPT-architectuur, dat beter in staat is om de inhoud en emotie van gesprekken te doorgronden.

Salmi benadrukte dat AI een ondersteunende rol moet spelen en kan op dit moment nog geen vervanger zijn van menselijke hulpverlening. Uit de experimenten met AI-tools bij 113 bleek dat hulpverleners AI-oplossingen vaak waardeerden als aanvullend hulpmiddel, vooral bij lastige gesprekken waar een second opinion wenselijk was. Een ander punt dat hij aanhaalde, was dat AI-modellen getraind moesten worden met gespreksdata van de hulplijn, waarbij de anonimiteit van de hulpzoekenden gewaarborgd bleef. Dit stelde de onderzoekers voor de uitdaging om effectieve modellen te bouwen zonder privacygevoelige informatie in gevaar te brengen.

Tijdens de presentatie werd ook een specifiek AI-ondersteuningssysteem gedemonstreerd. Dit systeem kon tijdens live-chatgesprekken suggesties doen op basis van eerder gevoerde gesprekken met vergelijkbare hulpvragen. Salmi gaf aan dat hulpverleners vooral baat hadden bij de gestructureerde inzichten die AI bood, bijvoorbeeld over veelvoorkomende gesprekspatronen en mogelijke effectieve interventies. Dit hielp niet alleen bij het verkorten van de responstijd, maar ook bij het verhogen van de effectiviteit van de gesprekken.

Daarnaast werd ingegaan op de rol van AI bij gespreksanalyses. Door middel van natuurlijke taalverwerking (NLP) werden chatgesprekken geanalyseerd om thema’s en emotionele toon te identificeren. Hierdoor kon beter worden ingeschat welke benadering het meest effectief was en welke hulpverleningsstrategieën werkten in specifieke contexten.

Een ander aspect dat Salmi aanstipte, was de implementatie van AI bij de evaluatie van gesprekken. AI werd ingezet om trends in gesprekken te herkennen en te analyseren of bepaalde hulpverleningsstrategieën meer succes hadden dan andere. Door feedback van zowel hulpzoekenden als hulpverleners te combineren met AI-analyse, kon 113 de effectiviteit van hun aanpak verbeteren.

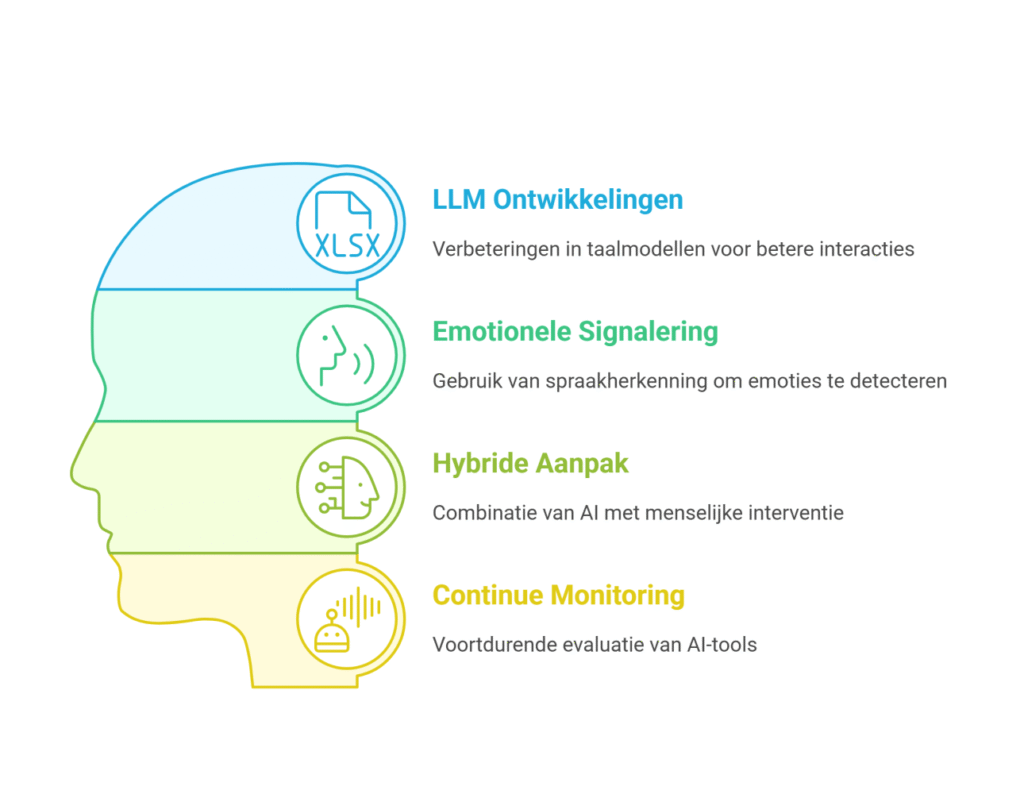

Tot slot besprak Salmi de mogelijkheden voor toekomstige toepassingen van AI binnen 113. Een belangrijke focus lag op de uitbreiding naar telefonische gesprekken. Hoewel AI momenteel voornamelijk wordt ingezet bij chatgesprekken, zou spraakherkenningstechnologie een volgende stap kunnen zijn. Hiermee zouden emotionele signalen in telefoongesprekken geanalyseerd kunnen worden om nog sneller in te schatten of een hulpzoekende in acute crisis verkeert.

Aanvullende inzichten uit het proefschrift van Salim Salmi

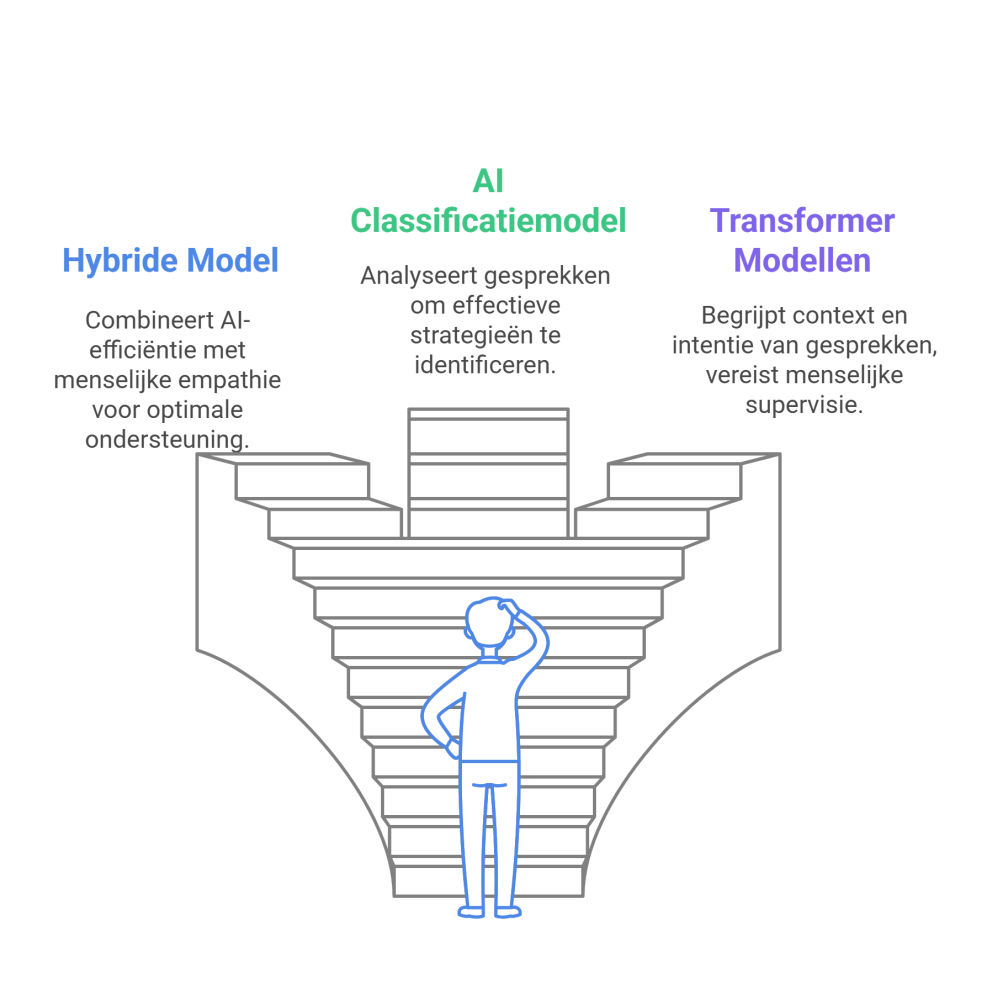

Naast de inzichten uit de presentatie biedt het proefschrift van Salmi verdere diepgang over de toepassing van AI bij 113 Zelfmoordpreventie. Een van de belangrijkste punten uit zijn onderzoek was de noodzaak van een hybride model waarin AI en menselijke hulpverleners samenwerken. AI kan helpen bij het identificeren van patronen en het doen van suggesties, maar de empathische interactie blijft een cruciaal onderdeel van effectieve hulpverlening.

Een ander belangrijk punt uit het proefschrift was de ontwikkeling van een AI-gebaseerd classificatiemodel voor het analyseren van de effectiviteit van gesprekken. Door gebruik te maken van machine learning-technieken werden gespreksfragmenten geanalyseerd en gecategoriseerd op basis van hun impact. Hierdoor kon worden vastgesteld welke gespreksstrategieën bijdroegen aan een positieve verandering in de gemoedstoestand van de hulpzoekende.

Ook werd in het proefschrift uitgebreid ingegaan op de technische aspecten van AI-modellen. Salmi onderzocht onder andere hoe transformer-modellen zoals GPT kunnen worden toegepast bij de analyse van suïcidale gesprekken. Een belangrijke conclusie was dat deze modellen goed in staat waren om de context en intentie van gesprekken te begrijpen, maar dat menselijke supervisie noodzakelijk bleef om verkeerde interpretaties te corrigeren.

Verder besprak Salmi de ethische en privacygerelateerde implicaties van AI binnen zelfmoordpreventie. Hij benadrukte dat AI-modellen voortdurend moeten worden geaudit om bias en onnauwkeurigheden te minimaliseren. Bovendien moeten hulpverleners worden getraind in het effectief gebruiken van AI-tools, zodat ze optimaal kunnen profiteren van de technologie zonder de menselijke kant van het werk uit het oog te verliezen.

Toekomstperspectieven

De toekomst van AI binnen 113 Zelfmoordpreventie is veelbelovend. Nieuwe ontwikkelingen in Large Language Models (LLM’s) kunnen de interactie tussen AI en hulpverleners verder verfijnen. Een mogelijke uitbreiding is de toepassing van AI in telefonische gesprekken, waarbij spraakherkenning helpt bij het identificeren van emotionele signalen.

Tegelijkertijd blijft een hybride aanpak essentieel: AI moet worden ingezet als hulpmiddel, niet als vervanger van menselijke hulpverleners. Door voortdurende monitoring en bijsturing kan AI een waardevolle bijdrage leveren aan effectievere en efficiëntere hulpverlening.

Conclusie

AI speelt een steeds grotere rol binnen 113 Zelfmoordpreventie en biedt innovatieve mogelijkheden om crisisinterventie te verbeteren. Hoewel de technologie nog in ontwikkeling is, tonen de eerste resultaten aan dat AI kan bijdragen aan snellere en effectievere hulpverlening. Tegelijkertijd moeten ethische en privacy-gerelateerde uitdagingen serieus worden genomen. De samenwerking tussen AI en menselijke hulpverleners lijkt vooralsnog de meest veelbelovende route naar een verbeterde zelfmoordpreventie in Nederland.